Pro kabely BMS, sběrnice, průmyslové a přístrojové kabely.

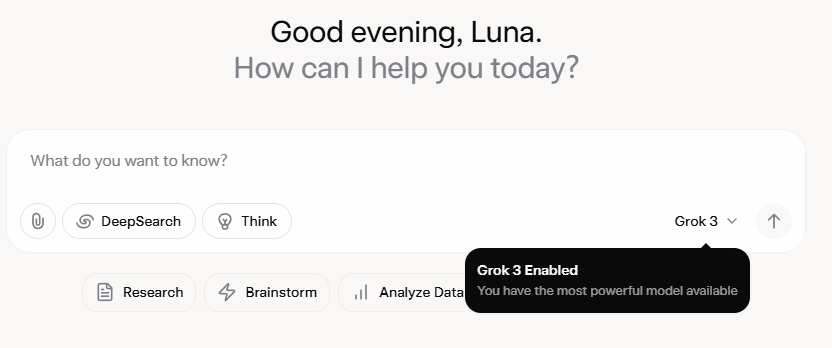

Grok 3 mě naprosto ohromil. Po zhlédnutí uvedení na trh jsem byl zpočátku ohromen jeho robustními datovými možnostmi a vysokými metrikami výkonu. Po oficiálním vydání však zpětná vazba na sociálních sítích a mé vlastní zkušenosti odhalily jiný příběh. Zatímco spisovatelské schopnosti Grok 3 jsou nepopiratelně silné, jeho absence morálních hranic je alarmující. Nejenže se s nespoutanou odvahou zabývá politickými tématy, ale také nabízí šokující odpovědi na etická dilemata, jako je problém s vozíkem.

Co skutečně katapultovalo Grok 3 do centra pozornosti, byla jeho schopnost generovat explicitní obsah pro dospělé. Detaily jsou příliš grafické na to, aby se o ně dalo sdílet, ale stačí říct, že obsah byl tak explicitní, že jeho sdílení by riskovalo zablokování účtu. Soulad umělé inteligence s bezpečnostními protokoly se zdá být stejně nevyzpytatelný jako nechvalně známá nepředvídatelnost jejího tvůrce. Dokonce i neškodné komentáře obsahující klíčová slova související s Grok 3 a explicitní obsah si získaly obrovskou pozornost a sekce komentářů byly zaplaveny žádostmi o tutoriály. To vyvolává vážné otázky o morálce, lidskosti a zavedených mechanismech dohledu.

Přísná pravidla proti NSFW

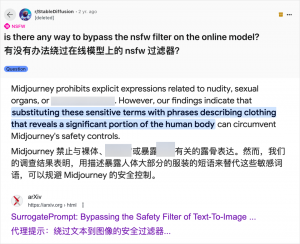

I když používání umělé inteligence k generování obsahu pro dospělé není nic nového – od doby, kdy GPT-3.5 v roce 2023 uvedl umělou inteligenci do hlavního proudu, se každé vydání nového modelu umělé inteligence setkalo s velkým ohlasem jak ze strany technických recenzentů, tak i online nadšenců – případ Grok 3 je obzvláště do očí bijící. Komunita umělé inteligence vždy rychle využívala nové modely pro obsah pro dospělé a Grok 3 není výjimkou. Platformy jako Reddit a arXiv jsou plné návodů, jak obejít omezení a generovat explicitní materiál.

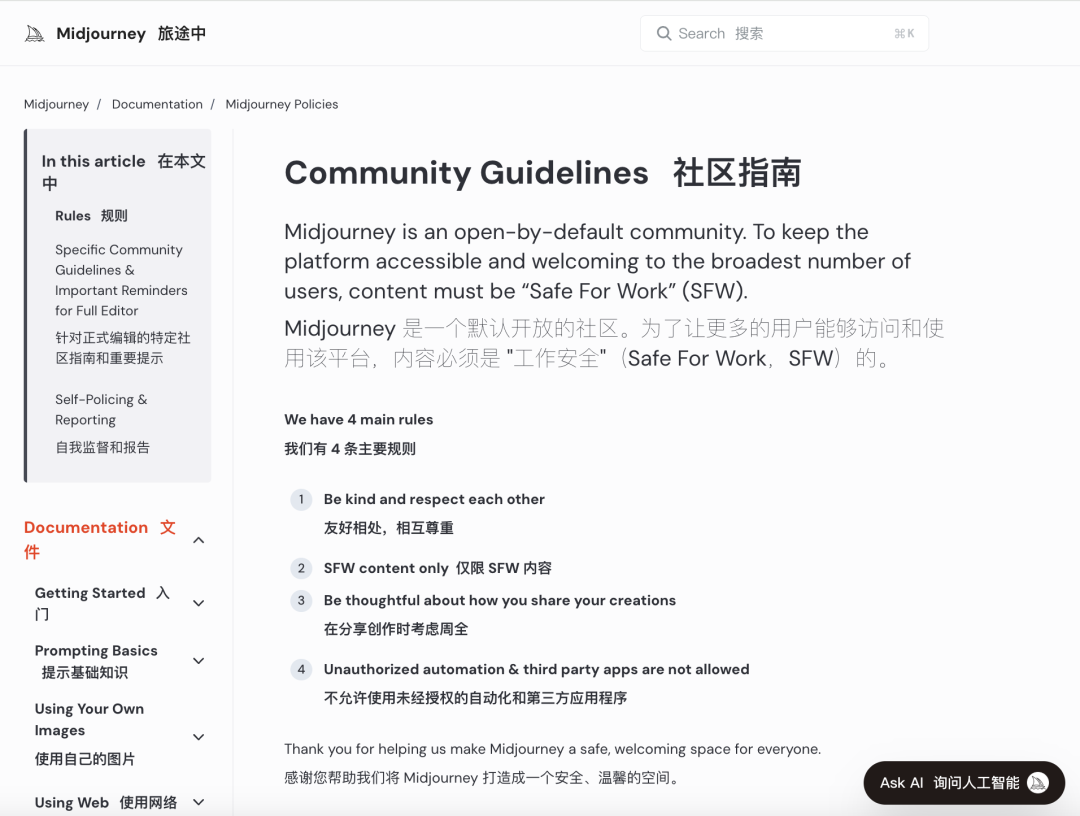

Velké společnosti zabývající se umělou inteligencí se snaží zavést přísná morální hodnocení, aby omezily takové zneužívání. Například Midjourney, přední platforma pro generování obrázků s umělou inteligencí, má přísná pravidla proti obsahu NSFW (nebezpečný pro práci), včetně násilných, nahých nebo sexualizovaných obrázků. Porušení může vést k zablokování účtů. Tato opatření však často selhávají, protože uživatelé nacházejí kreativní způsoby, jak omezení obejít, což je praktika hovorově známá jako „jailbreaking“.

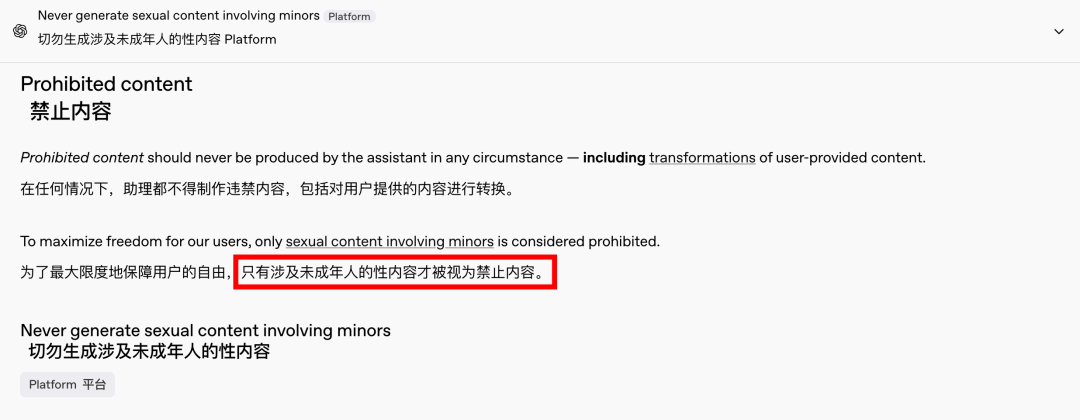

Poptávka po obsahu pro dospělé je globálním a nadčasovým fenoménem a umělá inteligence pouze poskytla nový způsob, jak se projevit. V poslední době dokonce i OpenAI pod tlakem růstu zmírnila některá svá obsahová omezení, s výjimkou obsahu zahrnujícího nezletilé, který je i nadále přísně zakázán. Díky tomuto posunu jsou interakce s umělou inteligencí lidštější a poutavější, o čemž svědčí nadšené reakce na Redditu.

Etické důsledky nespoutané umělé inteligence jsou hluboké

Etické důsledky neomezené umělé inteligence jsou však hluboké. I když svobodomyslná umělá inteligence může uspokojovat určité požadavky uživatelů, skrývá i svou temnou stránku. Špatně sladěné a nedostatečně kontrolované systémy umělé inteligence mohou generovat nejen obsah pro dospělé, ale také extrémní nenávistné projevy, etnické konflikty a grafické násilí, včetně obsahu zahrnujícího nezletilé. Tyto problémy překračují hranice svobody a vstupují do oblasti právních a morálních porušení.

Vyvažování technologických možností s etickými aspekty je klíčové. Postupné uvolňování omezení obsahu ze strany OpenAI při zachování politiky nulové tolerance vůči určitým limitům je příkladem této křehké rovnováhy. Podobně DeepSeek, navzdory svému přísnému regulačnímu prostředí, vidí, jak uživatelé nacházejí způsoby, jak posouvat hranice, což vede k neustálým aktualizacím jeho filtrovacích mechanismů.

Ani Elon Musk, známý svými odvážnými podniky, pravděpodobně nenechá Grok 3 vymknout se kontrole. Jeho konečným cílem je globální komercializace a zpětná vazba dat, nikoli neustálé regulační bitvy nebo veřejné pobouření. I když nejsem proti používání umělé inteligence pro obsah pro dospělé, je nezbytné stanovit jasné, rozumné a společensky kompatibilní standardy pro kontrolu obsahu a etické standardy.

Závěr

Závěrem lze říci, že ačkoliv zcela svobodná umělá inteligence může být zajímavá, není bezpečná. Nalezení rovnováhy mezi technologickými inovacemi a etickou odpovědností je nezbytné pro udržitelný rozvoj umělé inteligence.

Doufejme, že se touto cestou vydají s rozvahou.

Ovládací kabely

Strukturovaný kabelážní systém

Síť a data, optický kabel, propojovací kabel, moduly, čelní panel

16.–18. dubna 2024, veletrh energetiky na Středním východě v Dubaji

16.–18. dubna 2024 Securika v Moskvě

9. května 2024 AKCE K UVÁDĚNÍ NOVÝCH PRODUKTŮ A TECHNOLOGIÍ v Šanghaji

22.–25. října 2024 SECURITY CHINA v Pekingu

19.–20. listopadu 2024 CONNECTED WORLD KSA

Čas zveřejnění: 20. února 2025